前回簡単に説明した大偏差原理をエントロピーの概念を使って詳しく説明するために、今回はエントロピーについて説明します。また、カルバック・ライブラー情報量、最尤推定法などについても説明します。

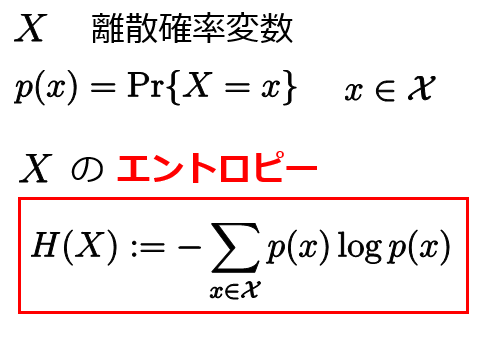

●エントロピー

これは確率変数のエントロピーへ次のように一般化されます。

エントロピーは平均情報量ともみなせます。

●カルバック・ライブラー情報量(相対エントロピー)

データはある確率分布に従う確率変数の実現値であると考えられることが多いです。しかし、その確率分布の形が分からないことがあり、得られたデータから真の確率分布を推定する必要がよくあります。推定した確率分布が真の確率分布にどれくらい近いかを表す尺度として次のカルバック・ライブラー情報量(相対エントロピー)というものがあります。

カルバック・ライブラー情報量の重要な性質として次の非負性があります。

カルバック・ライブラー情報量とエントロピーは次の関係があります。

よって、

となり、確率変数が一様分布に従うときにエントロピーは最大になることが分かります。

●最尤推定

確率分布 に従ってデータが生成されたとしましょう。しかし、

は我々には分からないとして、

を推定する必要があるとします。上で述べたことより、

の推定にカルバック・ライブラー情報量が利用できそうです。カルバック・ライブラー情報量の定義から

ということが分かります。 のときに

がすべての点

で成り立ちますので

を最大にすれば推定した確率分布 は真の確率分布

により近くなることが期待できます。しかし、そもそも真の確率分布

は未知なので平均大数尤度は直接計算できません。ここで注目すべき点はデータ

は真の確率分布

に従って得られているということです。つまり、データは確率変数の実現値であり、その確率変数は真の確率分布

に従います。このことから、データがたくさん得られたときには大数の法則が利用できて

となります。そこで、カルバック・ライブラー情報量 を小さくするためには

を最大にすれば良いことが分かります。最尤推定量はパラメータ付きの対数尤度

を最大にするパラメータ のことで、

を

の最尤推定と言います。つまり、最尤推定量

は

を満たす のことです。

データ数が十分に多いとき最尤推定法はある意味で最適な推定法になっていることを示せます。このことはまた今度詳しい説明を書くつもりです。

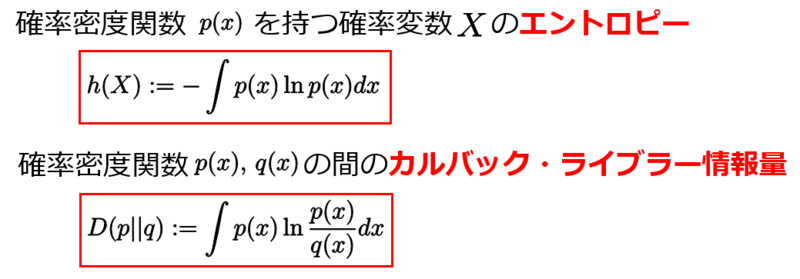

●連続確率変数のエントロピーとカルバック・ライブラー情報量

今までの議論は確率変数が離散値を取る場合を考えていましたが、確率変数が連続値を取る場合に対してもエントロピーやカルバックライブラー情報量が次のように定義されます。

離散値の時と同様にカルバックライブラー情報量の定義式から最尤推定法の考え方が出てきます。

確率変数が連続値をとるとき変分法を使うと、ある制約条件の下でエントロピーを最大化するような確率密度関数を求めることができます。例えば、平均と分散が一定のもとでエントロピーが最大になる分布はガウス分布であることを示すことができます。変分法については今後詳しく説明するつもりです。

●参考文献

記事を書くときに参考にした文献です。

(1) 情報理論をしっかり勉強するならこれ

Elements of Information Theory (Wiley Series in Telecommunications and Signal Processing)

- 作者: Thomas M. Cover,Joy A. Thomas

- 出版社/メーカー: Wiley-Interscience

- 発売日: 2006/06/30

- メディア: ハードカバー

- クリック: 7回

- この商品を含むブログ (1件) を見る

(2) カルバックライブラー情報量と最尤推定のつながりのところを参考にした

- 作者: 青山秀明,家富洋,池田裕一,相馬亘,藤原義久

- 出版社/メーカー: 共立出版

- 発売日: 2008/10/23

- メディア: 単行本

- 購入: 3人 クリック: 22回

- この商品を含むブログ (7件) を見る

●予告

大偏差原理について詳しく説明します。